Здравствуйте, гость ( Вход | Регистрация )

|

14 Jan 2023, 00:48 14 Jan 2023, 00:48

Сообщение

#21

|

|

пират с чёрной меткой Сообщений: 23 658 Спасибо сказали: 12931 раз |

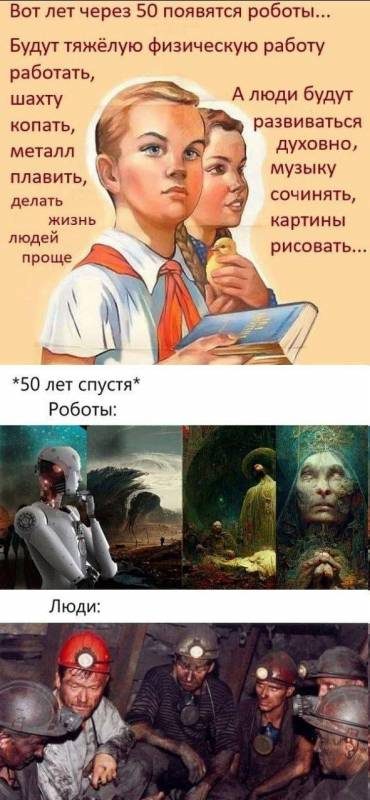

Черт знает. возможно, у меня никогда не было творческих амбиций (честно затрудняюсь сказать – хорошо это или плохо). Ну т.е. у меня никогда не было проблем с форматом "работать в стол". К тому же мотивация "хочу стать профессиональным художником, потому что они дофига зарабатывают" – это точно не про художников)) Поэтому творчество остается такой же нишей, какой и была, для меня это примерно также, как если появится робот, который умеет купаться в море или гулять по лесу лучше меня. Ну и что? Мне теперь по лесу не гулять?!))) А если прогресс достигнет такой стадии, что скормив роботу 2-5 твоих оригинальных работ, он начнёт выдавать "то, что ты подумал, но решил, что это невозможно"?То есть, будет более ты, чем ты сам? -------------------- Давший быка на убой не выпросил и печень на жаркое.

|

|

|

|

14 Jan 2023, 00:54 14 Jan 2023, 00:54

Сообщение

#22

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

А если прогресс достигнет такой стадии, что скормив роботу 2-5 твоих оригинальных работ, он начнёт выдавать "то, что ты подумал, но решил, что это невозможно"? То есть, будет более ты, чем ты сам? "Вы что, и конфеты есть за меня будете?"(с) Я к чему это все описывал?)) Удовольствия от процесса робот за меня не получит. -------------------- |

|

|

|

19 Jan 2023, 02:41

(Сообщение отредактировал Axolotl - 19 Jan 2023, 12:17) 19 Jan 2023, 02:41

(Сообщение отредактировал Axolotl - 19 Jan 2023, 12:17)

Сообщение

#23

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Размышлял по поводу датасетов. Пришел пока к такому, возможно, наивному видению предпочтительного развития ситуации.

Да, помимо количества базы должно быть и качество, т.е. ручная корректировка. Плюс, база должна быть общедоступной. Как этого достичь? База должна собираться вручную массовыми усилиями людей. Чтобы всё не скатилось в хаос, должна быть "параноидально-бюрократическая" система на манер википедии или Rateyourmusic. Чистить ошибочные результаты, грохать картинки в плохом качестве. Если это работы художника, менять плохое качество на хорошее. Работа титаническая, но и людей дофига. C миру по нитке, как говорица. Увы, копирасты будут неизбежно вставлять палки в колёса, но тут я не знаю что делать. В идеале к сохранению художественного наследия, даже без контекста обучения нейросетей, уже давно должна бы была подключиться какая-то международная культурная организация, которая бы поддерживала и наполняла виртуальную библиотеку мировых художеств в высоком качестве и занималась оцифровкой всех этих художеств современным оборудованием, сотрудничая с музеями и частными коллекциями (но это я губозакаточную машинку где-то обронил). Это вообще печалит, что многие замечательные художники и иллюстраторы (даже классические с мировым именем) вообще присутствуют в сети только в виде каких-то картинок "500x300", ужасно отснятых и жутко пожеванных многократным джпегом. Я понимаю, что обучение сети подобного масштаба - процесс жутко затратный. Полагаю, что несколько сот тыщ долларов или даже ближе к миллиону (буду рад боле точной инфе), это дофига, но на том же краудфандинге и не такие суммы поднимались и на меньшие проекты. -------------------- |

|

|

|

19 Jan 2023, 03:14 19 Jan 2023, 03:14

Сообщение

#24

|

|

Сейчас чем-то занят. Как и всегда. Сообщений: 546 Спасибо сказали: 402 раза |

Axolotl, а что, собственно, мешает художникам добавлять, что они против использования своих работ в датасетах?

Берём работу, указываем художника, источник (как на каком-нибудь Данбоору). В случае чего, можно перепроверить, точно ли работа принадлежит этому художнику и дал ли он на это своё согласие. И, как минимум, собрать среди тех, которые не против поделиться своим стилем. Ну и добавлять ватермарку, что, мол, сделано в стиле такого-то такого. Если будут нарушающие правила на данном этапе - делать их нежелательными лицами у обоих сторон - и создателей нейросетей-художников, и простых художников. К тому же, подобный "общий враг" позволит сгладить углы между уже сотрудничающими художниками и теми, кто использует их работы для "высшей цели". -------------------- I'm a furry dragoness, 'cause I can.

|

|

|

|

19 Jan 2023, 10:16 19 Jan 2023, 10:16

Сообщение

#25

|

|

Immortal Сообщений: 23 594 Спасибо сказали: 19753 раза |

Собственно, проблему "отравления" датасетов нейросеток результатами их собственной работы уже подняли. Хочется добавить немного своих соображений.

• Та самая проблема, о которой со злорадным восторгом пишет каждый второй в интернетах, переключившись с обличения ковидного заговора ("ха, говнохудожники, готовьтесь к тому, что через пару лет вы никому не будете нужны, и вообще уже сейчас нейросети удовлетворяют потребности простых людей намного дучше вас, убогих, и не требуют таких затрат") — она, к сожалению, вполне реальна. Нездоровый ажиотаж вокруг "художественных" нейросеток сознательно раздувается, очевидно что их чем дальше, тем более уверенно будут использовать для давления на иллюстраторов и принуждения их к худшим условиям труда. Плюс эффективные манагеры — зачастую катастрофически некомпетентные кадры, к тому же очень падкие на "новые уникальные технологии, позволяющие снизить издержки". В общем, "низкоранговых" художников будут "мочить" в ближайшие годы. Мне видится так, что в пессимистичном сценарии будет задрана планка вхождения в индустрию, при этом вопросами доведения квалификации кадров до необходимого уровня и их поддержкой на этом этапе заниматься никто не будет и вкладываться в это не станет, а существовавшие компетенции этого плана будут утеряны, и преемственность подготовки специалистов разорвётся. Будет предполагаться, что начинающие художники должны будут сами проходить через "мясорубку" скукожившегося рынка труда начинающих спецов в значительно ухудшившихся со всех сторон условиях и успешно "победить в конкурентной борьбе", а компании, палец о палец не ударяя, будут ждать уже состоявшихся профессионалов со стажем и портфолио, готовых работать за "новичковые" деньги. Собственно, такая картина уже наблюдается во многих айтишных областях, безо всяких ИИ, к примеру, и дальше тоже будет только хуже. • Уже сейчас Артсейшн, Девиантарт и прочие популярные площадки массово засоряются результатами работы нейросетей, публикуемых без атрибуции в кач-ве ИИ-арта. Как минимум администрация Артстейшена уже прямо сказала, что не собирается ничего с этим делать (иронично, ведь по концепции это площадка для публикации портфолио для демонстрации нанимателям — и теперь они сами профанируют собственный концепт, идут вразрез с позиционированием своей площадки и отваживают ядро своей аудитории; ну, видимо, посчитали, что поддержать ИИ-истерию — более "денежный" ход). При этом в сети большое количество "активистов", которые массово вбрасывают на площадки хреновенькие результаты работы нейросетей, не помечая их как ИИ-арт, сознательно — для них это выражение политической позиции, как и поливание помоями художников в комментариях. Я лично сам недавно сталкивался с тем, что в каких-то случаях при банальной гуглёжке стимпанковых картинок большая часть начальных результатов выдачи поисковика (в привате) была представлена результатами работы нейросеток, залитыми на крупные площадки. В данном случае это совершенно пустяковый курьёз — но в то же время тревожный звоночек. Ну и вспомнился мелкий пример из схожей области, но до нейросетевого бума: Пинтерест, будучи сам по себе отличным агрегатором референсов и способом сохранить их от потери при удалении на страницах-источниках, в какой-то момент сильно осложнил поиск с помощью обычных поисковиков, засоряя картинковыдачу многократно дублирующимися и далеко не всегда подходящими результатами. В какой-то момент это было прямо бедой. Правда, в итоге алгоритмы, видимо, подкорректировали, и пару лет как такое стало наблюдаться намного меньше. • Крупные компании, конечно, утверждают, что в свои датасеты они не заливают работы современных художников, не разрешивших их использование в таком качестве, однако есть все основания считать, что это банальное враньё. Это хрен проверишь, и точечный damage control в случае палева будет более дешёвым, чем необходимость заранее организовывать комплексные мероприятия по дополнительной фильтрации работ и по покупке лицензий (одно дело, когда они покупаются через стоки и т. п. — но для датасетов, чтобы сделать дорого-богато, нужно очень много работ современных прикладных художников приличного уровня, и с ними бы пришлось бы договариваться индивидуально или через не очень крупные — по крайней мере, по сравнению со стоками — агентства). Ну и как бы очевидно, что для работы использовали в т. ч. Пинтерест. Это что касается крупных компаний. Для обучения же локальных мелких stand-alone нейросеток просто льют все подряд работы по тегам с danbooru и подобных ресурсов. Либо не задумываясь о каких-то там авторских правах, либо плевав, так как имеют "бизнес-план" поживиться на чужих работах, продавая результат их переработки на Патреоне и т. п. (тот самый тип персонажей, который недавно занимался "мамкиным майнерством"), либо задумываясь о них в том самом ключе "политического манифеста против ненавистных художников". • Процесс выдавливания "низов" прикладных художников с рынка, если он развернётся, ещё больше ускорит процесс засорения интернетов результатами работы нейросеток, усугубляя проблему "отравления" датасетов. Кроме того, это, как и возможный разрыв в процессах подготовки, чревато значительным оскуднением (по крайней мере, относительным) притока новых "здоровых" работ для обучения сетей. • Основным способом борьбы с "отравлением" датасетов, который может быть использован на практике в ближайшее время, мне пока видится тот же, что используется для текстовых ИИ и некоторых других — а именно нанимать кучу аутсорсеров в странах с низкой оплатой труда. Но тут, правда, возникает проблема с тем, что уровень квалификации "переворачивателей пингвинов" должен быть значительно более высоким, чем в случае с текстами, при этом объёмы обрабатываемой ими информации должны быть больше, организована она менее тривиально и намного хуже поддаётся поиску и обработке простыми алгоритмами. -------------------- |

|

|

|

19 Jan 2023, 12:10

(Сообщение отредактировал Axolotl - 19 Jan 2023, 12:35) 19 Jan 2023, 12:10

(Сообщение отредактировал Axolotl - 19 Jan 2023, 12:35)

Сообщение

#26

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

• Основным способом борьбы с "отравлением" датасетов, который может быть использован на практике в ближайшее время, мне пока видится тот же, что используется для текстовых ИИ и некоторых других — а именно нанимать кучу аутсорсеров в странах с низкой оплатой труда. Но тут, правда, возникает проблема с тем, что уровень квалификации "переворачивателей пингвинов" должен быть значительно более высоким, чем в случае с текстами, при этом объёмы обрабатываемой ими информации должны быть больше, организована она менее тривиально и намного хуже поддаётся поиску и обработке простыми алгоритмами. А предложенный мной выше "народный" вариант чем кажется плохим? Ну помимо проблемы с копирастами(( Твой же вариант больше под коммерческие базы типа той же Midjourney. Цитата Axolotl, а что, собственно, мешает художникам добавлять, что они против использования своих работ в датасетах? Да можно, но там еще есть такой момент, что использование "чистых" стилей художников на самом деле штука довольно базовая и далеко не самая интересная. Нейросеть отлично справляется со смешением разных стилей. И это не просто "смешать стиль одного скетч-художника с другим скетч-художником", сетка отлично справляется и со смешением, скажем, графических стилей и фотографии, причем с тонко настраиваемыми пропорциями смешения, и результаты порой очень удивительные. Т.е. в итоге можно намешать такого, что стиль одного художника если и будет присутствовать, то в виде скорее того, что про художников людей обычно говорят "чувствуется влияние", "вдохновлялся"))) И это еще не все возможности.    -------------------- |

|

|

|

09 Feb 2023, 11:29 09 Feb 2023, 11:29

Сообщение

#27

|

|

laughed as one fey Сообщений: 12 166 Спасибо сказали: 20586 раз |

Цитата а именно нанимать кучу аутсорсеров в странах с низкой оплатой труда. https://www.aljazeera.com/opinions/2023/1/2...igital-age-work broke: этические установки ИИ как культурное осмысление работ лучших интеллектуалов запада от трех законов робототехники до всяких там юдковских за 300к/нсек woke: этические установки ИИ как культуррегерство от неистребимого пуританизма американских акционеров, пересказанное кенийцам за 2 бакса/час |

|

|

|

08 Mar 2023, 20:23 08 Mar 2023, 20:23

Сообщение

#28

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Кстати, пятая версия Midjourney не за горами. Правда, как я понял, там будет не такой существенный разрыв, как между 3-й и 4-й. -------------------- |

|

|

|

23 Apr 2023, 11:52 23 Apr 2023, 11:52

Сообщение

#29

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Кстати, если что, то я довольно активно слежу за происходящим в Midjourney. Поэтому если интересна какая-то информация – спрашивайте. Дело в том, что сейчас очень много новостей о MJ иногда просто из разряда "слышал звон", а иногда и намеренные спекуляции, выдирания из контекста и прочее.

Ну и пользовался ей уже немало, поэтому если смогу, то буду рад помочь и в техническом плане. -------------------- |

|

|

|

27 Apr 2023, 10:10

(Сообщение отредактировал Axolotl - 27 Apr 2023, 11:32) 27 Apr 2023, 10:10

(Сообщение отредактировал Axolotl - 27 Apr 2023, 11:32)

Сообщение

#30

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Немного новостей, как чуть более старых, так и новых про MJ.

То, что вышла пятая версия, думаю, уже не новость, это было почти полтора месяца назад. Пятая версия всё еще находится в положении "бета", и дефолтной является четвертая. Дефолтной пятёрка станет после того, как к ней прикрутят дефолтную "эстетику". Что это за зверь такой в тех. плане понятно не до конца. Авторы называют текущую версию "unopininonated", как бы это теоретически даёт большую гибкость для достижения разных результатов, но и усложняет работу с ней. Т.е. версия с эстетикой как бы немного додумывает за вас запрос, потенциально делая его более художественным, а версия без – требует этого от вас. "Теоретически" потому, что реально сравнить и проанализировать пока не с чем, т.к. четвертая версия была сразу с "эстетикой", и сравнивать можно лишь "opininonated" четвертую с "unopininonated" пятой, и, понятно, тут слишком много лишних факторов, т.к. это в принципе разные модели. Авторы обещают, что "unopininonated" версия останется в виде специального параметра. Так что можно будет пользоваться и той, и другой, ну и сравнить в итоге. Про разницу между четвертой и пятой я расписывать не буду, но если вдруг интересно, то могу. Также не так давно была добавлена фича "Describe", т.е. Image to Text режим, где вы скармливаете картинку, а сетка делает вам её описание. Подобные инструменты были давно для Stable Diffusion, но тут, понятно, результат более заточен именно под Midjourney. Зато, благодаря этому, появилась возможность чуть-чуть заглянуть под капот MJ. Из даваемых описаний видно, что разрабы MJ научили сетку понимать всякие узкие термины с Aesthetics Wiki, большинство которых я лично даже не знал до этого. Огромное кол-во всевозможных ~core и ~punk терминов. Скажем, "Mommy's on the phonecore" или "Avocadopunk"))). Это уже мои домыслы, но я полагаю, что все эти термины больше не затем, чтобы ими пользовались люди, а скорее, чтобы добавить этакие пулы внутренних эстетических ассоциаций и тем самым разнообразить получаемые результаты, при этом не выбиваясь из темы. Параллельно идёт работа сразу и над шестой, и над седьмой версией. Дело в том, что там независимые друг от друга улучшения. Шестая будет иметь новый обученный датасет с дополненной и почищенной от грязи базой. А в седьмой идёт работа над лучшим пониманием языка. Также авторы интригуют некими секретными фичами, над которыми сейчас активно идёт работа. Но что это такое – неизвестно. Буквально на днях прошел тест новой системы модерации контента. Возможно, вы знаете, что MJ позиционируется как PG13+, поэтому там запрещено делать NSFW контент, и поэтому там забанены многие слова, связанные с сексом и всякой брутальщиной. Из-за этого случаются проблемы там, где система блокирует невинные в определённом контексте слова. Новая система будет использовать, хехе, другой AI, который будет в свою очередь На правах слухов, хоть и из первых рук. Есть и еще ряд штук, над которыми идёт работа и эксперименты. Над некоторыми работа идёт уже давно, но неизвестно в какой версии они появятся если появятся вообще. Из известного это, скажем, outpainting, а также эксперименты с рисовальными инструментами, где можно будет прямо рисовать условные скетчи, а сетка это интерпретировать. Были разговоры и про потенциальный интерактивный режим, где сетка будет вам давать десяток мелких превьюшек того, в какую сторону может развиваться картинка, выбрав одну, вы вступаете на новую развилку с еще десятком вариантов, пока не добьётесь того, чего вам хочется. Были и разговоры про новые способы взаимодействия с тем, как описать сетке нужные эстетические параметры, скажем, настраивать эстетику при помощи других картинок или используя более абстрактные "вайбовые" слова, описывающие некие настроения, эмоции. Как я понял, часть этого просто пока обдумывается, часть уже имела практические эксперименты, и то, появятся ли эти инструменты, зависит от того, как они себя покажут в закрытых тестах. -------------------- |

|

|

|

02 Aug 2023, 17:02

(Сообщение отредактировал Axolotl - 02 Aug 2023, 17:03) 02 Aug 2023, 17:02

(Сообщение отредактировал Axolotl - 02 Aug 2023, 17:03)

Сообщение

#31

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Снова немного новостей.

В Midjourney прикрутили инструменты Outpainting и Pan, про который я писал в прошлый раз. Кто не знает, это такая функция, когда уже сгенерированную картинку можно как бы расширить, дорисовать со всех сторон, словно увести назад виртуальную камеру. Pan – то же самое, но дорисовывает не со всех сторон, а только с одной, т.е. создание панорамы. Ну вот простой пример Outpainting: Вот первая сгенерированная картинка  Одна итерация отдаления  Несколько итераций отдаления  При этом, отдаляя, можно добавить что-то в описание или даже полностью его изменить. Скажем, здесь было просто к уже существующему запросу было добавлено слово "огонь"  В качестве огня сетка "решила" использовать свечки)) Что-ж, интересное решение. На подходе Inpainting. Это когда ты выбираешь какую-то область уже сгенерированной картинки и хочешь либо просто её "перерисовать", либо самому вписать, что нужно добавить именно в это место. Точнее, они уже его сделали, но не могут добавить, т.к. это не позволяет текущий API дискорда. Как я понял, Дискорд уже пообещал добавить поддержку нужных функций, но пока еще этого не случилось. Свой сайт, где можно будет генерировать картинки без дискорда они потихоньку пилят. Вообще, Дэвид Хольц очень неохотно решался на введение этих инструментов, которые уже давно были в Stable Disffuion, объясняя это тем, что разработка нейросети всё еще пока похожа на блуждание в потьмах на ощупь, и чем больше всяких прикрученных инструментов, тем более тяжеловесной становится система и меньше гибкости для разработчиков в плане изменения основного кода, либо же им придётся дорабатывать каждый прикрученный инструмент под каждое изменение алгоритма. В общем-то, здравая позиция, но и с инструментами побаловаться хочется. Шестая версия MJ, видимо, немного задержится. Как я понял, новая модель с дотренированным датасетом у них уже есть и работает, но они хотят, чтобы качественный разрыв между версиями был более существенным, поэтому дорабатывают. -------------------- |

|

|

|

22 Aug 2023, 15:52

(Сообщение отредактировал Axolotl - 22 Aug 2023, 15:55) 22 Aug 2023, 15:52

(Сообщение отредактировал Axolotl - 22 Aug 2023, 15:55)

Сообщение

#32

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Добавили наконец-то Inpainting. В Midjourneyеё назвали "Vary Region". Это фича, с помощью которой можно выделить определённый участок сгенерированной картинки и перерисовать его либо просто, либо с пояснением того, что в нем нужно добавить.

Просто перерисовка, чтобы пофиксить неудавшиеся места типа неудавшихся пальцев, глаз или просто перерисовать лицо если не нравится выражение – это работает на ура. Перерисовка с пояснением работает уже менее предсказуемо, иногда выдает странные результаты или выбивается из стиля, создавая близкое к коллажу, но нередко вполне себе адекватно выходит. Полагаю, что будут еще допиливать как-то. Вот, например, добавил зверюху рядом с девочкой.   Inpainting поверх просто загруженной картинки они сознательно решили пока не вводить, т.к. у этого большой потенциал для использования в не очень хорошем контексте, а вокруг нейросетей и без того много негативной шумихи. -------------------- |

|

|

|

23 Aug 2023, 02:56 23 Aug 2023, 02:56

Сообщение

#33

|

|

пират с чёрной меткой Сообщений: 23 658 Спасибо сказали: 12931 раз |

Вот, например, добавил зверюху рядом с девочкой. Просто здорово!-------------------- Давший быка на убой не выпросил и печень на жаркое.

|

|

|

|

23 Aug 2023, 10:40 23 Aug 2023, 10:40

Сообщение

#34

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Вот, например, добавил зверюху рядом с девочкой. Просто здорово!Кстати, это пример, когда нейросеть использовалась в том числе и для практических нужд. Для цифровой афиши мероприятия. У нас просто есть небольшое некоммерческое волонтёрское арт-пространство, где происходит всякое разное: концерты любых жанров от бардов до диджеев, еженедельные дни настольных игр (которые жестко захватил маджонг), просмотры кино, лекции/мастерклассы, литературные/поэтические встречи и т.п. Вот эта картинка собственно для афиши на будущее (на зиму) для регулярного формата "Гитарный круг", когда приглашаются просто все желающие любого технического уровня и жанра и по кругу поют что-то под гитару (хоть своё, хоть чужое) или просто слушают. И вот нейросеть очень помогла нам в создании афиш для всяких таких ивентов, т.к. взять просто чужую картинку с инета можно, но это и противозаконно без согласия автора, и в целом менее прикольно. Делать коллаж или тем более рисовать под каждый такой ивент – это здорово, раньше мы так иногда делали, но мы и так сколько можем личного свободного времени отдаём ради того, чтобы место жило, и далеко не всё успеваем. Позволить себе художника за зарплату тоже не можем (у нас вообще никого нет за зарплату), т.к. аренда помещения – это собственно то, куда уходят все донаты, и даже не всегда их хватает. Применение, конечно, узкое, но локально очень спасает. Первые две еще в четвертой версии Midjourney делались.     -------------------- |

|

|

|

27 Sep 2023, 22:23 27 Sep 2023, 22:23

Сообщение

#35

|

|

|

Immortal Сообщений: 1 247 Спасибо сказали: 607 раз |

А кто может подсказать нормальную нейросеть, которая умеет рисовать средневековое оружие? А то чаще всего кроме меча, лучка и копья нейросеть толком ничего не знает.

Лучше без регистрации, качество и скорость вторично наверное. Я как понимаю есть вариант искать нейросеть куда можно закидывать референсы, что будет хоть каким-то подспорьем для генерации. |

|

|

|

28 Sep 2023, 08:56 28 Sep 2023, 08:56

Сообщение

#36

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Да, с некоторыми категориями объектов пока сложно. Проблема простая: нет достаточной базы данных с описанием. В базе много картинок всякого оружия, но не всё оно описано, и когда дело доходит до всяких тонкостей, то пока что проблема. Скажем, бабочек или грибы сетка делает хорошо, но если ты захочешь какой-то конкретный вид бабочек из энциклопедии или конкретный редкий вид грибов, то результат не всегда правильный. Технической загвоздки нет, просто расширять датасет, снабжая информацией. Но это должен кто-то сделать: собрать сотни картинок по каждому виду бабочек, грибов, пород собак, оружия и т.п.

Есть всякие дообученные модельки для Stable Duiffusion, но, насколько я знаю, дополнительной текстовой инфы они не содержат, это просто стилистический вектор. Максимум, что пока видится, что можно сделать, это обучать модельки под каждый вид объекта. Скажем, сделать отдельную модельку, которая хорошо генерит один определённый вид бабочек. Но это уже надо ставить SD и обучать, т.е. довольно геморное и ресурсоёмкое занятие. MJ обещают, что будут в дальнейшем расширять базу знаний сетки о нашем мире. -------------------- |

|

|

|

02 Nov 2023, 12:20

(Сообщение отредактировал Axolotl - 02 Nov 2023, 12:29) 02 Nov 2023, 12:20

(Сообщение отредактировал Axolotl - 02 Nov 2023, 12:29)

Сообщение

#37

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Недавно писал в теме нейросетей про новую версию Dall-E и про то, как круто они продвинули точность понимания запросов, и как плохо у них все стало с настройкой стиля.

Тут подоспела Midjourney и сделал прорыв как раз по второму аспекту – настройки стиля. Они выкатили новую фичу: Style Tuner Как это примерно работает: можно задать запрос с параметром /tune, и сетка сгенерирует от 16 до 128 пар сетов изображений. Но не просто, а внутренне случайным образом переставляя параметры, как раз касающиеся эстетики (черт знает как оно там работает на уровне математики). При этом намеренно интерпретируя стилистически запрос в самых разных стилистических изгибах. Вот можно посмотреть примеры именно самого тюнера: https://tuner.midjourney.com/zBZpm3s https://tuner.midjourney.com/ZBuN1IF После этого можно выбирать одно или несколько изображений, стиль которых тебе нравится, близок, или наоборот ты хочешь скрестить "бульдога с носорогом", и на основе выбора тебе выдается итоговый идентификатор стиля, который потом уже можно применять к любому запросу. Более того, можно потом плавно управлять силой влияния этого стиля или смешивать разные. У меня просто мозг взорвался от этого! Сам я еще на практике не применял, т.к. каждый месяц оформлять подписку для меня все-таки дороговато. Подозреваю, там, как и все с нейросеткой, имеет множество непредсказуемостей. Они сами написали, что стили будут по-разному вести себя в зависимости от комбинации с запросом, но в теории выглядит очень круто. Что я еще вижу в этом помимо огромного потенциала для настройки стиля картинок. Я вижу огромный стог сена, подложенный на случай если копирасты таки добьются своего. Dall-E, я уже писал, в новой версии запретила использовать имена современных художников, подменяя их примерным усредненным текстовым описанием стиля. Midjourney же создала просто какой-то алхимический котёл-конструктор, в котором можно попросту создавать уникальные стили, не привязанные к конкретному художнику. Найденное решение Dall-E по сравнению с этим выглядит как откровенный детский сад. Если разорюсь на подписку в ближайшее время (а попробовать новый инструмент дико хочется), то еще напишу про результаты собственных экспериментов. -------------------- |

|

|

|

25 Feb 2024, 20:26

(Сообщение отредактировал Axolotl - 25 Feb 2024, 20:53) 25 Feb 2024, 20:26

(Сообщение отредактировал Axolotl - 25 Feb 2024, 20:53)

Сообщение

#38

|

|

I must gather my party before venturing forth Сообщений: 5 074 Спасибо сказали: 17756 раз |

Давно ничего не писал, хотя новости имеются.

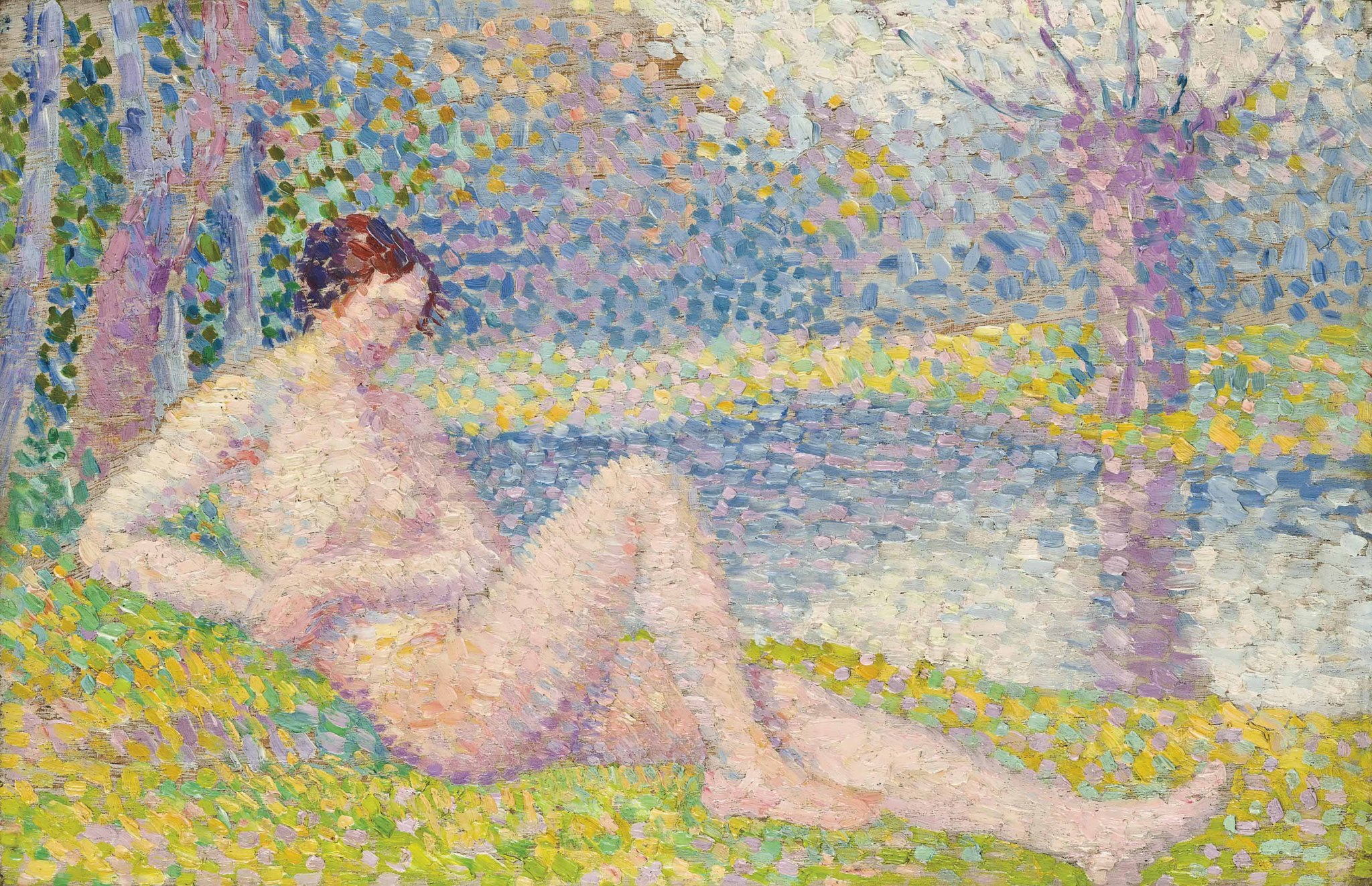

V6 Во-первых, вышла шестая версия Midjourney. Правда, пока все еще находится в статусе альфа-версии. В целом шестёрка мне нравится, хотя ожидал (ну, скорее мечтал) о большем прорыве. Основные достижения – это улучшение понимания сложных детальных запросов . Да, оно действительно сильно улучшилось по сравнению с пятой версией, хотя третью Dall-E именно в этом аспекте они не догнали. Второе – возможность генерировать картинки с текстом. Работает оно, как и Dall-E 3, далеко не идеально, тоже постоянно пропускает, переставляет буквы, но немного терпения и удачи, и вполне можно добиться адекватных результатов. Возможно, делает ошибки в тексте чаще, чем Dall-E, но не сильно чаще, а возможность перегенерировать именно выбранный участок картинки с лихвой восполняет отставание. Увы, в шестерке вновь увеличилось кол-во проблем с анатомией по сравнению с 5.2, но еще рано судить, т.к. альфа-версия. Style Reference Также вскоре после выхода шестерки выкатили новую киллер-фичу под названием Style-Reference. И вот об этом хотелось бы подробнее. Для меня лично, это одна из самых весомых фич, появившихся в MJ. Что делает фича? Вы даете ей картинку, дополняете самим текстовым запросом, а сетка пытается сымитировать именно стиль. Возможность загрузить референсную картинку была давно, но там сетка брала с картинки всё: композицию, позу, черты лица, объекты, сюжет, и всё, что касается стиля. Тут же сетка игнорирует сам сюжет, пытаясь подражать только стилю и атмосфере. Да, задача противоречивая в самой своей концепции, т.к. где в том или ином случае заканчивается стиль (форма), а начинается сюжет (содержание) – вопрос спорный и для человека. Но как-то работает. Работает далеко не идеально, но гораздо лучше, чем я лично смел надеяться. Про неидеальность. С какими-то референсами подражает стилю более точно, с какими-то хуже, где-то совсем мимо. Но! Это не главная крутость фичи. Первое главное – это устойчивость стиля. При обычном текстовом запросе стиль от картинки к картинке может сильно вилять в разные стороны, тут же он гораздо более устойчив. В этом смысле не так важно, что стиль скопировался неточно, если он хорош сам по себе, зато весьма устойчив. Второе главное – это еще большие возможности для чисто стилистических экспериментов и исследования эстетики как таковой. Дело в том, что референсов можно дать сразу несколько, да еще и указать вес каждого, и сетка будет пытаться их смешать. А ведь дать ей можно не только близкие стили, но и наоборот, что-то предельно далекое. Более того, можно указывать общий вес этого самого стиля, смешивать с текстовым описанием стиля (скажем подсунуть картинку с акварельным рисунком, а в описании сказать "фотография" или наоборот) или использовать стили художников из описания, можно использовать референсы из картинок в обычном режиме, про который я писал, также их смешивая. Рулить прочими параметрами. В общем, получился очень мощный алхимический котел по синтезу уникального стиля, порой дающий удивительные и непредсказуемые результаты. Увы, чем больше веса задается стилю, тем больше сетка игнорирует ваш запрос и своевольничает, но тем не менее потенциал огромный. Наверное, интересно будет глянуть на практические примеры фичи.     Как видим, передача стиля не совсем точная, хотя и довольно близкая. Но также видим, что стиль стабилен и мне лично он очень нравится. Теперь посмотрим на пример смешения.       А вот пример, где смешаны две картинки в виде стилистического референса + обычный референс + стиль художника из текстового описания + аниме режим MJ (называется Niji)  P.S. Авторы говорят, что хотят пересмотреть функционал этой фичи, расширив её возможности, сделав выбор того, чему именно будет подражать сетка. Скажем, чтобы она подражала только цветовой гамме или, наоборот, игнорировала цвета с картинки. Также обещают вот уже совсем скоро добавить похожую фичу, Character Reference, где с референсной картинки сетка будет пытаться повторить именно черты лица персонажа. Что важно для тех, кто хочет использовать сеть для создания историй, комиксов, иллюстраций к своей книге/игре и т.п. -------------------- |

|

|

|

|

2 чел. читают эту тему (гостей: 2, скрытых пользователей: 0)

Пользователей: 0

| Текстовая версия | Сейчас: 1 May 2024 - 09:17 |

|

Copyright by Алексей Крючков

Programming by Degtyarev Dmitry |

|